Algunos beneficios de registrarse en nuestra revista:

- El registro te permite consultar todos los contenidos y archivos de Lawi desde nuestra página web y aplicaciones móviles, incluyendo la app de Substack.

- Registro (suscripción) gratis, en 1 solo paso.

- Sin publicidad ni ad tracking. Y puedes cancelar cuando quieras.

- Sin necesidad de recordar contraseñas: con un link ya podrás acceder a todos los contenidos.

- Valoramos tu tiempo: Recibirás sólo 1 número de la revista al mes, con un resumen de lo último, para que no te pierdas nada importante

- El contenido de este sitio es obra de 23 autores. Tu registro es una forma de sentirse valorados.

Impacto y Aplicación de la Inteligencia Artificial (IA) en el Derecho

Este elemento es un complemento de los cursos y guías de Lawi. Ofrece hechos, comentarios y análisis sobre el Impacto de la Inteligencia Artificial en el Derecho. Puede interesar consultar los “Aspectos Internacionales de los Derechos de Propiedad Intelectual“, la “Inteligencia Artificial Generativa”, el Impacto de la Inteligencia Artificial en la Industria Editorial, y la “Protección de la Propiedad Intelectual para la Inteligencia Artificial“.

Impacto de la Inteligencia Artificial en el Derecho y de la IA Generativa

La IA ofrece enormes oportunidades de aplicación en el Derecho. La IA aumenta la productividad racionalizando no una gran tarea, sino innumerables tareas pequeñas. Los abogados pueden utilizar la IA generativa para elaborar memorandos, redactar escritos, idear y aportar ideas, redactar y negociar contratos, revisar facturas legales o de proveedores, llevar a cabo la diligencia debida para fusiones, etcétera.

Los abogados también pueden utilizar la IA para la investigación jurídica. Consideremos, por ejemplo, que los abogados utilizan herramientas basadas en IA para resumir instantáneamente información compleja, presentando la información de forma fácilmente digerible y comprensible. Las herramientas de investigación jurídica de IA generativa también forman a los estudiantes, interactuando con ellos, respondiendo a sus preguntas y proporcionándoles información.

La aplicación de la IA al Derecho

Esto es sólo el principio. La IA se encuentra todavía en una fase temprana de desarrollo. Las iteraciones posteriores serán más potentes. Las aplicaciones futuras podrían conducir a la democratización del asesoramiento jurídico, con un mayor acceso a los servicios legales y a la justicia. O tal vez allanen el camino para la resolución de casos basada en la IA, con un sistema entrenado por la jurisprudencia y la legislación que arroje resultados desprovistos de prejuicios. Las aplicaciones, en el ámbito de la educación, también podrían proporcionar simulaciones del mundo real a los abogados en formación, permitiéndoles practicar en un tribunal realista, con muchas de las presiones que ello conlleva.

Las aplicaciones actuales de la IA están cambiando la naturaleza del Derecho de formas que no podíamos prever. Y es probable que las futuras aplicaciones de la IA hagan exactamente lo mismo.

El impacto de la IA en el mundo real

Las aplicaciones de la inteligencia artificial son infinitas, sus beneficios numerosos y su potencial enorme. Pero el éxito de su aplicación depende de un uso responsable: tener en cuenta las repercusiones en el mundo real y mitigar los distintos riesgos. La IA desempeña un papel cada vez más importante en la investigación jurídica, la toma de decisiones legales, la resolución de disputas y, de hecho, en los litigios, por lo que es esencial que los abogados practiquen la diligencia debida.

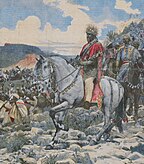

Tal día como hoy de 1889, el día siguiente a instituirse el Primero de Mayo por el Congreso Socialista Internacional, Menilek II de Etiopía firma el Tratado de Wichale con Italia, concediéndole territorio en el norte de Etiopía a cambio de dinero y armamento (30.000 mosquetes y 28 cañones). Basándose en su propio texto, los italianos proclamaron un protectorado sobre Etiopía. En septiembre de 1890, Menilek II repudió su pretensión, y en 1893 denunció oficialmente todo el tratado. El intento de los italianos de imponer por la fuerza un protectorado sobre Etiopía fue finalmente frustrado por su derrota, casi siete años más tarde, en la batalla de Adwa el 1 de marzo de 1896. Por el Tratado de Addis Abeba (26 de octubre de 1896), el país al sur de los ríos Mareb y Muna fue devuelto a Etiopía, e Italia reconoció la independencia absoluta de Etiopía. (Imagen de Wikimedia)

Tal día como hoy de 1889, el día siguiente a instituirse el Primero de Mayo por el Congreso Socialista Internacional, Menilek II de Etiopía firma el Tratado de Wichale con Italia, concediéndole territorio en el norte de Etiopía a cambio de dinero y armamento (30.000 mosquetes y 28 cañones). Basándose en su propio texto, los italianos proclamaron un protectorado sobre Etiopía. En septiembre de 1890, Menilek II repudió su pretensión, y en 1893 denunció oficialmente todo el tratado. El intento de los italianos de imponer por la fuerza un protectorado sobre Etiopía fue finalmente frustrado por su derrota, casi siete años más tarde, en la batalla de Adwa el 1 de marzo de 1896. Por el Tratado de Addis Abeba (26 de octubre de 1896), el país al sur de los ríos Mareb y Muna fue devuelto a Etiopía, e Italia reconoció la independencia absoluta de Etiopía. (Imagen de Wikimedia)

Los abogados comercian con su reputación. Su reputación se sustenta en un trabajo de alta calidad, ideas y respuestas, todo lo cual depende de la recopilación de datos precisos e irrefutables de fuentes de confianza. No es sólo la información lo que importa a los abogados, sino el trasfondo de esa información, las suposiciones implícitas en esa información y la información que no se ha incluido.

Por eso la transparencia es tan importante para los profesionales del Derecho. Utilizar IA opaca en lugar de IA transparente puede tener consecuencias previsibles en el mundo real, del tipo que los abogados suelen tratar de evitar, como la desinformación o la introducción de sesgos. Los abogados no pueden, o no deben, por ejemplo, utilizar información generada por sistemas que dependen de sesgos introducidos. Los sistemas de IA mal desarrollados hacen precisamente eso, porque el sesgo puede introducirse en muchas fases y las prácticas habituales en informática no están diseñadas para detectarlo.

Como explican algunos responsables de inteligencia artificial, las herramientas de Inteligencia Artificial pueden dar consejos tendenciosos y no éticos, por lo que deben utilizarse con mucho cuidado, sobre todo en esta fase inicial. Pensemos, por ejemplo, que el uso de IA opaca en la contratación puede introducir prejuicios raciales, de género, de edad o de otro tipo. La introducción de prejuicios no sólo es profundamente contraria a la ética y perjudicial desde el punto de vista comercial, sino también ilegal.

La desinformación es otro riesgo. Los sistemas de IA opacos difunden información errónea porque se les ha suministrado información falsa o desfasada, o porque no disponen de la información correcta y, por tanto, inventan información, lo que se conoce como “alucinaciones”. Consideremos el impacto en el mundo real: los abogados utilizan esa información en litigios legales. Depender de información errónea puede socavar la justicia y la reputación del abogado.

Los sistemas de IA pueden evitar la parcialidad y la desinformación con supervisión humana. Unas fuentes de contenido cuidadosamente seleccionadas permiten una total transparencia sobre los datos de entrada -y, por tanto, de salida-, y los modelos estadísticos pueden eliminar posibles problemas. Otras medidas preventivas y reactivas, como la aplicación de herramientas de depuración a los algoritmos de aprendizaje supervisado o a los modelos de procesamiento del lenguaje natural, garantizan que los sistemas de IA proporcionen la información correcta.

La necesidad de concienciación en IA

Algunas investigaciones muestran un alto grado de concienciación sobre la IA generativa. También señalan una conciencia de los impactos adversos en el mundo real: ausencia de responsabilidad, sesgo introducido, difusión de información errónea. Está claro que la IA ofrece ventajas sustanciales, pero la clave para aprovecharlas, tanto en términos éticos como de aplicación efectiva, radica en utilizar las plataformas de IA adecuadas de la manera correcta, con un conocimiento constante de las repercusiones en el mundo real.

La IA definirá el futuro del Derecho. Es esencial que los abogados y los bufetes se mantengan al día. Por este motivo, algunos proveedores y universidades, por ejemplo, ofrecen acceso a seminarios web, contenido producido por expertos y actualizaciones cruciales sobre los próximos productos y tecnologías de IA. Estos tipos de programas ayuda a los profesionales del derecho a pasar de la teoría de la IA a su aplicación, a comprender los riesgos de la IA y, en última instancia, a utilizar la IA de forma responsable y eficaz.

Los sistemas de inteligencia artificial (IA) generativa y el Derecho

Todos los sistemas de inteligencia artificial (IA) generativa son falibles. El aprendizaje automático encuentra patrones en enormes conjuntos de datos y produce resultados basados en esos patrones. El sistema de IA no necesita dirección humana para producir resultados. Y, si carece de dirección humana, si se basa únicamente en big data y ML, el sistema de IA producirá, tarde o temprano, resultados engañosos, sesgados o simplemente erróneos.

- Cómo una nueva ampliación puede cambiar la UE

- “¡Dios, envíanos sacerdotes!”

- Una semana del peaje para turistas de Venecia: “Nos sentimos como monos en un zoo”

- Milei: "Un paso fundamental para sacar a Argentina del pantano"

- Irlanda protesta por los migrantes que llegan desde Reino Unido para no ser enviados a Ruanda

La supervisión humana es necesaria a lo largo de todo el ciclo de vida de un sistema de IA, desde la introducción del primer dato hasta el control del último resultado. Los seres humanos deben responsabilizarse del desarrollo, el uso y los resultados de los sistemas de IA. Una supervisión eficaz mejorará la calidad, aumentará el rendimiento, generará confianza entre los usuarios y, en última instancia, garantizará el éxito.

A continuación exploramos cómo la supervisión humana reduce el riesgo, amplifica los beneficios e impulsa la responsabilidad general en la práctica de la ley, y examinamos las mejores formas de aumentar la supervisión humana de los sistemas de IA.

La importancia de la supervisión humana en los sistemas de IA

Una queja habitual sobre los sistemas de IA es la falta de transparencia. Algunas soluciones no revelan las fuentes de datos, no revelan los derechos de autor (si no han llegado a un acuerdo con dichos autores, generalmente), no proporcionan información sobre los algoritmos utilizados y no destacan a las personas responsables de construir y mantener el sistema. Si algo sale mal, no hay rendición de cuentas. Si no hay rendición de cuentas, es más probable, estadísticamente, que las cosas vayan mal.

Basado en la experiencia de varios autores, mis opiniones y recomendaciones se expresarán a continuación (o en otros lugares de esta plataforma, respecto a las características en 2024 o antes, y el futuro de esta cuestión):

Por eso es tan importante la supervisión humana: crea responsabilidad. Los sistemas de IA son complejos, polifacéticos y, en ocasiones, impredecibles. Pueden cometer errores. La responsabilidad limita esos errores y garantiza que las personas los corrijan para evitar que se repitan.

La responsabilidad también aporta un juicio moral a un sistema amoral, lo que es especialmente importante cuando se utiliza la IA generativa en ámbitos delicados, como el derecho. Consideremos, por ejemplo, que un abogado puede construir un caso utilizando IA. Si la información es incorrecta (como le ocurrió a un abogado de Trump), el abogado habrá creado un riesgo ético y legal, por no mencionar el posible daño a su reputación.

La supervisión humana también mitiga otros riesgos importantes de la IA. Puede minimizar la introducción de sesgos mediante pasos sencillos. Puede garantizar que las entradas se seleccionan cuidadosamente y son de mucha mayor calidad, al tiempo que garantiza una gobernanza eficaz de los datos. Puede garantizar que los resultados sean más precisos, más fiables, libres de alucinaciones y más actualizados. En resumen, la supervisión humana mejora drásticamente los resultados de la IA y aumenta la confianza de los usuarios. El inconveniente es que, si los datos seleccionados de entrada son pocos, los resultados podrían no ser los esperados, por falta de entrenamiento de la IA.

Garantizar la supervisión humana en los sistemas de IA

En el caso de los sistemas de IA creados para fines específicos, es fundamental que las organizaciones se apoyen en los conocimientos de expertos. En el sector jurídico, por ejemplo, las personas con un profundo conocimiento del Derecho deberían supervisar y mejorar continuamente el rendimiento de los sistemas de IA, introduciendo sus conocimientos especializados para crear soluciones de IA mucho mejores.

La supervisión humana debe comenzar con la introducción de datos. Los expertos deben curar cuidadosamente los datos utilizados para entrenar los sistemas y luego evaluar constantemente esos datos, buscando cualquier valor atípico o anomalía y corrigiendo las fuentes para mantener una alta calidad. Pueden minimizar las imprecisiones y los sesgos mediante procedimientos de reducción de sesgos y herramientas de detección algorítmica.

Las evaluaciones de la calidad de los datos también pueden ayudar al seguimiento. Las evaluaciones ponen de relieve los valores que faltan, los valores atípicos y los problemas generales de los datos. Los resultados permiten a los humanos limpiar los conjuntos de datos y gestionar los datos que faltan. Y lo que es más importante, las evaluaciones de datos garantizan que los datos sean representativos y reflejen el escenario real en el que opera la IA.

Las organizaciones son responsables de los resultados de la IA y siempre deben tener en cuenta el impacto en el mundo real. Por eso los sistemas de IA también deben aplicar la supervisión humana a través de auditorías. Al más alto nivel, los sistemas de IA pueden realizar una evaluación del rendimiento de los modelos, desarrollando una serie de métricas -exactitud, precisión, velocidad, relevancia, etc.- y juzgando los resultados en función de las métricas. Las deficiencias deben quedar claras a lo largo del proceso.

Los sistemas de IA deben evaluar los resultados en situaciones reales, solicitando la opinión de las personas que utilizan el sistema. Los abogados, por ejemplo, son los que más probabilidades tienen de detectar problemas, entender el contexto y detectar errores.

La supervisión humana depende, pues, de los conocimientos del experto y de la insustituible sabiduría compartida de la comunidad. Los mejores sistemas de IA son sistemas responsables, en los que las personas se encargan de la supervisión humana y la rendición de cuentas, lo que minimiza los riesgos y amplifica los beneficios.

Practicar la supervisión humana en los bufetes de abogados

Los abogados y los bufetes también deberían aplicar la supervisión humana. Pueden realizar sus propias auditorías, asegurándose de que los sistemas de IA cumplen las normas sugeridas. Los bufetes y abogados pueden profundizar en términos de auditoría de sistemas, adoptando un enfoque más técnico.

Herramientas como las explicaciones agnósticas de modelos interpretables locales (LIME) y las exPlanificaciones aditivas de Shapley (SHAP) exploran la explicabilidad e interpretabilidad de los sistemas de IA, por ejemplo. Se trata de técnicas que aproximan cualquier modelo de aprendizaje automático de caja negra a un modelo local interpretable para revelar lo que ocurre en los sistemas e identificar posibles problemas.

LIME y SHAP no deberían ser necesarios a menudo, ya que los abogados, en la búsqueda de un riesgo mínimo, deberían utilizar sistemas de IA que ofrezcan una mayor transparencia, y una mayor responsabilidad. Pero los sistemas de IA no son estáticos: evolucionan, mejoran y también se deterioran (como se ha visto en Chat GPT, según su propio foro), por lo que un sistema que antes era transparente puede volverse cada vez más opaco, o más “perezoso”. Por eso es necesaria una auditoría periódica.

La formación y la orientación también permiten a los abogados practicar una supervisión humana eficaz. Los despachos de abogados deben formar a su personal sobre las mejores formas de aplicar la supervisión humana a los resultados. Esto significa que los profesionales del derecho deben ser capaces de identificar los productos potencialmente defectuosos, comprobar la información esencial y de alto riesgo, tomar nota de las violaciones de datos y las exposiciones, etc. Además, los abogados deben ser conscientes de la forma de supervisar los productos, y deben saber cómo comunicar esa información a los propios sistemas, para que éstos puedan mejorar los resultados futuros, minimizar los riesgos y crear mejores modelos para todos.

Revisor de hechos: ST

[rtbs name=”practica-juridica”] [rtbs name=”politicas-economicas”]Recursos

[rtbs name=”informes-jurídicos-y-sectoriales”][rtbs name=”quieres-escribir-tu-libro”]Notas y Referencias

Véase También

- Organización Mundial de la Propiedad Intelectual

- Propiedad literaria y artística

- Derecho a la imagen

- Derechos de autor

- Software de código abierto

- Reproducción de documentos

- Publicación de acceso abierto

- Protección de datos

- Profesion jurídica

- Derecho de la información

- Piratería audiovisual

- Excepción cultural

- Piratería informática

- Gestión de derechos digitales

- Propiedad industrial

- Política de competencia

- Política industrial

- Conocimientos técnicos

Bibliografía

▷ Esperamos que haya sido de utilidad. Si conoce a alguien que pueda estar interesado en este tema, por favor comparta con él/ella este contenido. Es la mejor forma de ayudar al Proyecto Lawi.

Por eso los abogados deben elegir sistemas que ofrezcan una rendición de cuentas adecuada, una visión humana eficaz e información precisa. Pero la mayoría de los sistemas están basados en Chat GPT, y alguno en Gemini.